使用Ollama来部署deepseek(基础)

安装Ollama

打开Ollama官网,下载对应的版本

https://ollama.com/下载完成后安装,基本上无脑下一步即可。

查看安装结果

安装完成后,打开Ollama,不会有操作界面,只会在后台静默运行

打开网页,输入:

http://localhost:11434/查看运行状态,若返回:Ollama is running,则代表安装、运行成功。

下载Deepseek R1

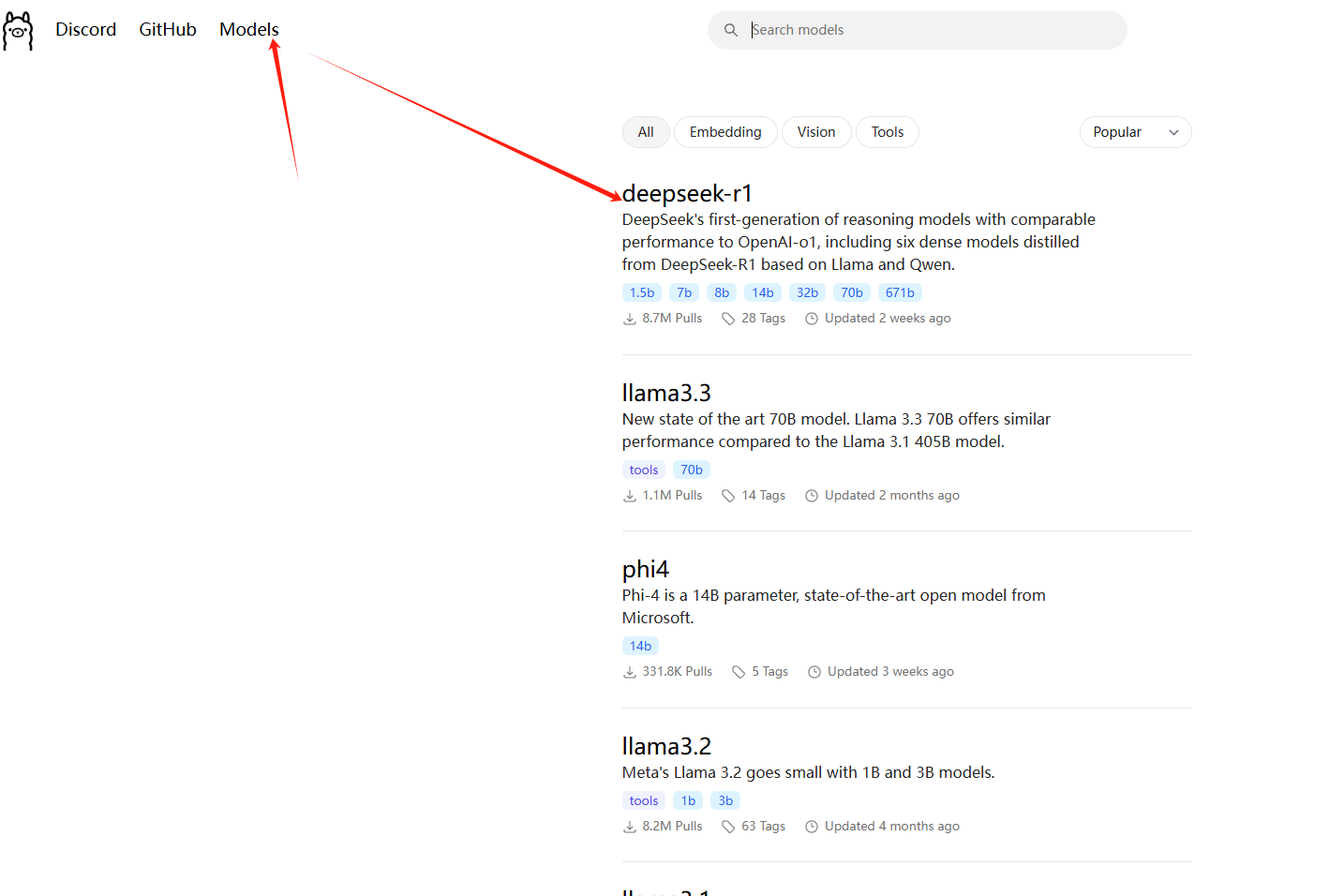

进入ollama官网,点击左上方的Models,找到R1模型

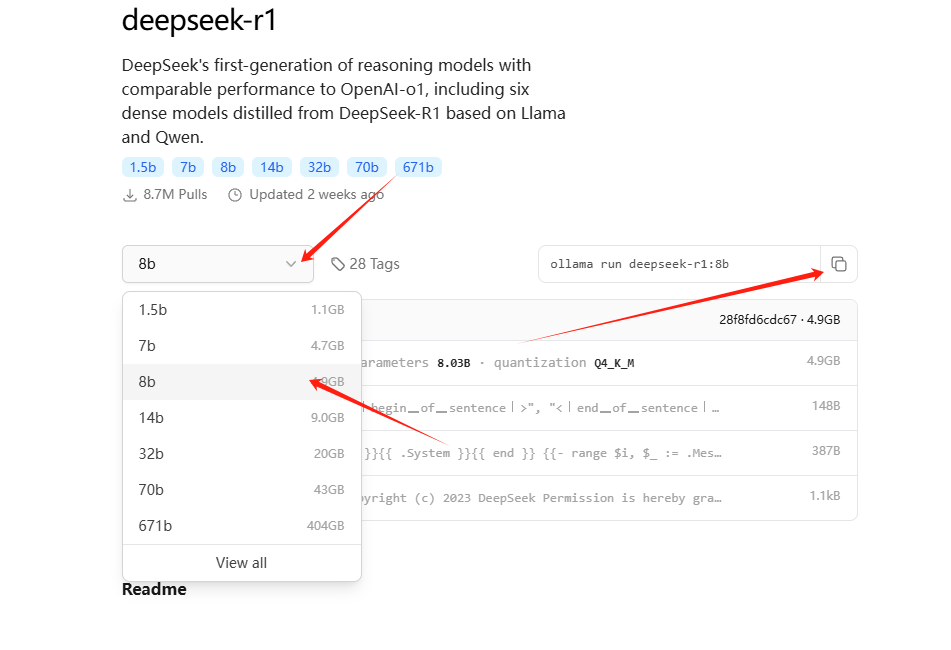

根据自己的显卡性能,选择对应的模型,复制运行的指令

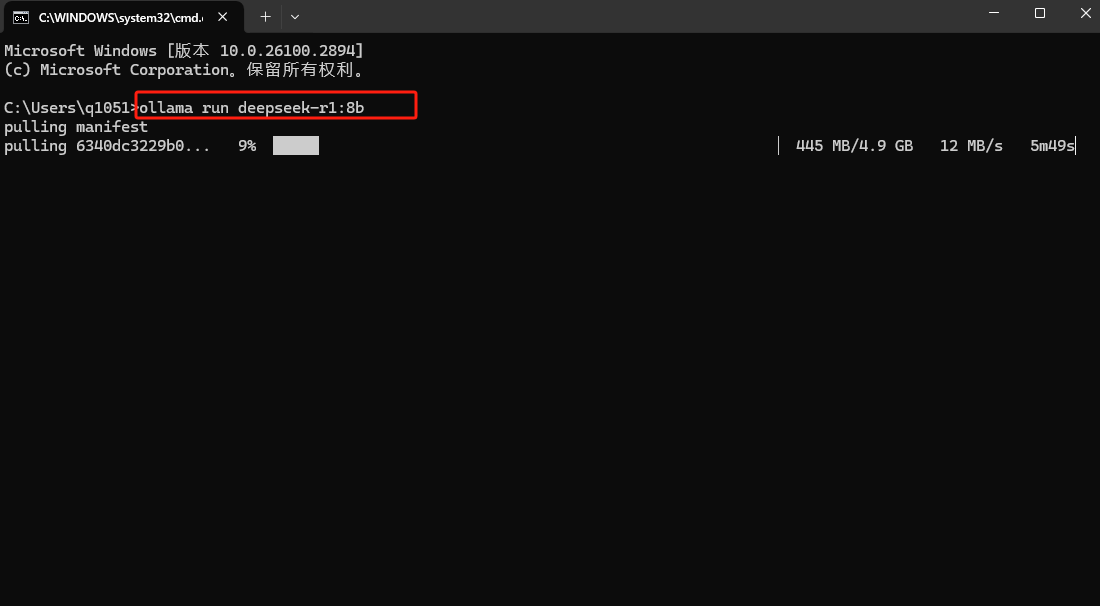

按WINDOWS+R,打开运行界面,输入CMD,打开命令提示符界面,将复制的指令在命令提示符中运行,等待安装完成即可:

安装完成后会自动运行,在命令提示符中能够自动问答就是安装成功了。

后续想要再打开,只需要重新输入:ollama run deepseek-r1:8b(这里就是你安装的模型指令)

Ollama使用起来相对偏专业一些,但拓展性感觉比较好,更进一步的调试,后续更新。

本文是原创文章,采用 CC BY-NC-ND 4.0 协议,完整转载请注明来自 三九

评论

匿名评论

隐私政策

你无需删除空行,直接评论以获取最佳展示效果