使用LM部署本地化离线deepseek(基础)

AI-摘要

Tianli GPT

AI初始化中...

介绍自己

生成本文简介

推荐相关文章

前往主页

前往tianli博客

一、下载并安装LM studio

下载安装

前往官网下载LM studio:https://lmstudio.ai/

根据自己的系统选择下载,安装的时候无脑下一步,默认安装位置即可。

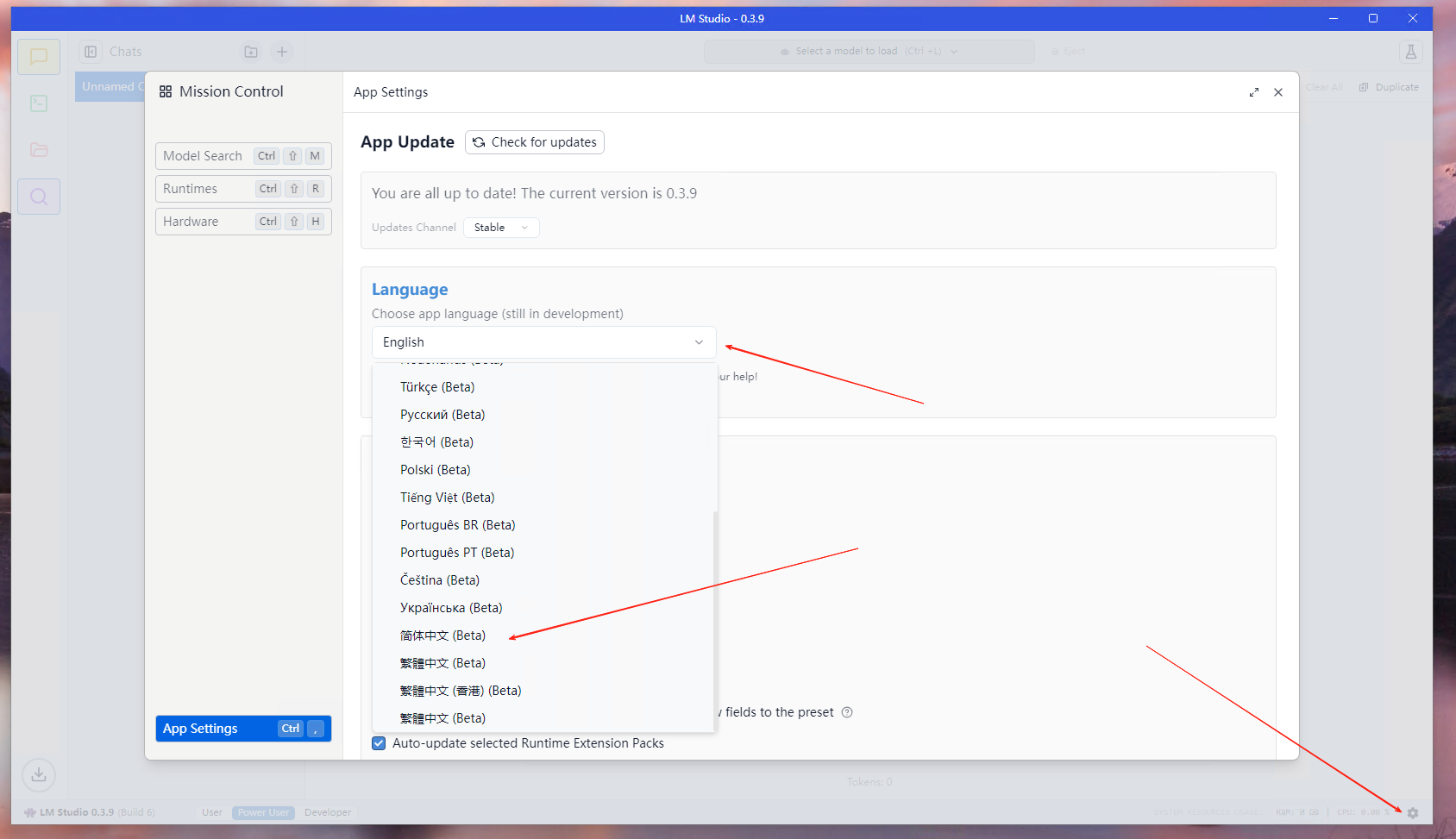

调整中文

打开程序后,点击页面右下角齿轮,选择Language,切换为中文即可

二、载入AI模型

选择模型

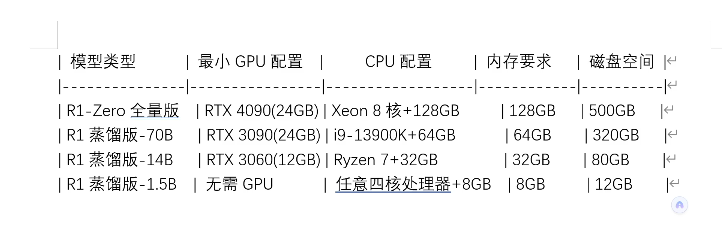

根据自己的电脑配置,选择需要使用的AI模型,大致参考如下:

常规玩游戏的显卡选择14B的模型即可,选太高的模型,输出结果会比较慢

下载模型

科学上网:https://huggingface.co/

搜索deepseek 的 R1模型,搜索的时候要带GGUF,例如 deepseek R1 GGUF。

GGUF代表这个模型可以使用LM Studio进行一键部署

提供个人网盘下载模型(5M下载小水管):

http://www.carlos9527.cn:12345/#/shareTemp?st=3VlTE如果有夸克会员,可以用这个:

https://pan.quark.cn/s/069f8788a116导入模型

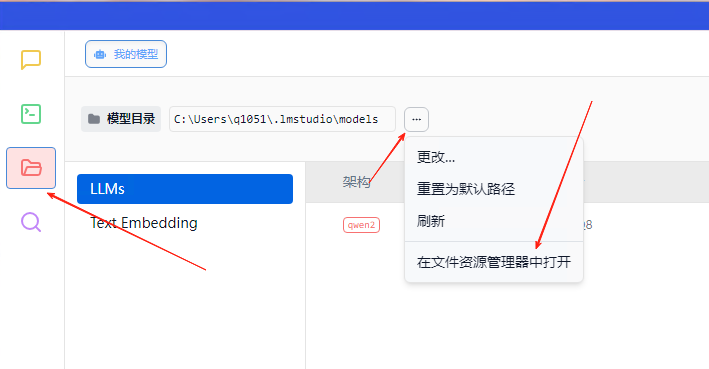

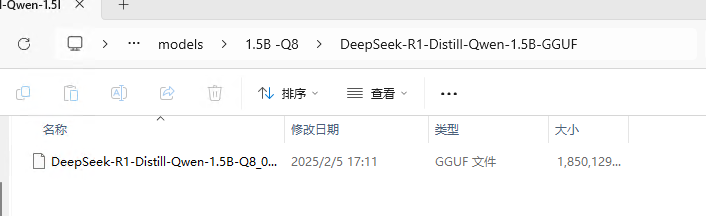

把完成下载后的模型,放到模型对应的文件夹下面。

这里建议更改一下模型目录,文件夹命名需要全英文

注意,放进目录的模型,还要至少套2个文件夹,第一个文件夹为模型命名,第二个文件夹命名随意,最后把模型放在第二个文件夹内,如图:

模型基础配置

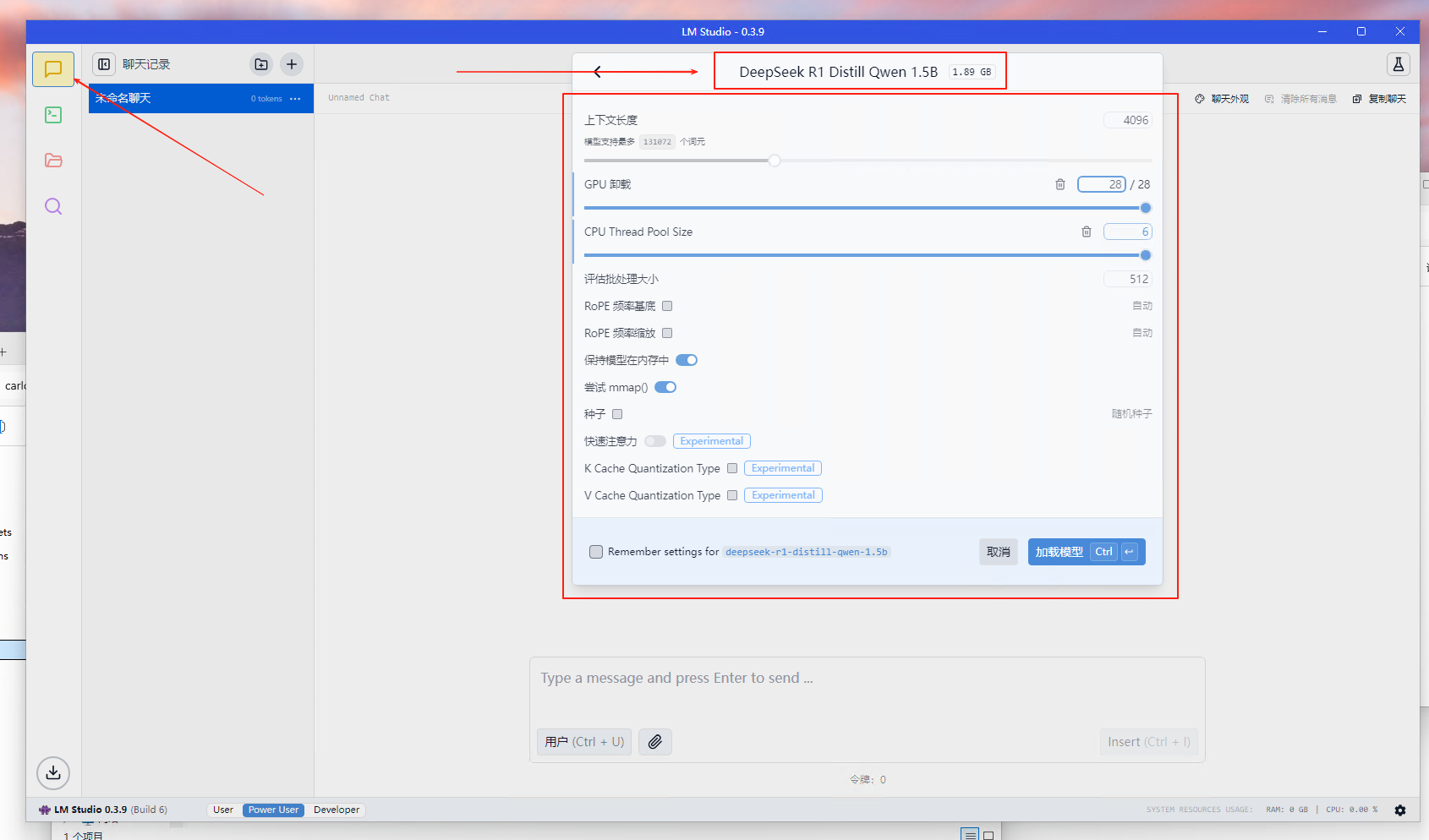

回到聊天菜单,切换到该模型。切换后会有菜单选择

根据自己的电脑配置情况,拉一下模型的上下文长度、GPU卸载、CPU Thread Pool Sise(线程)

选完以后点加载模型即可

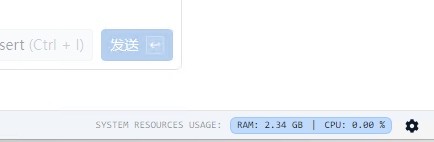

加载完成后,右下角会显示模型占用的电脑性能

使用模型

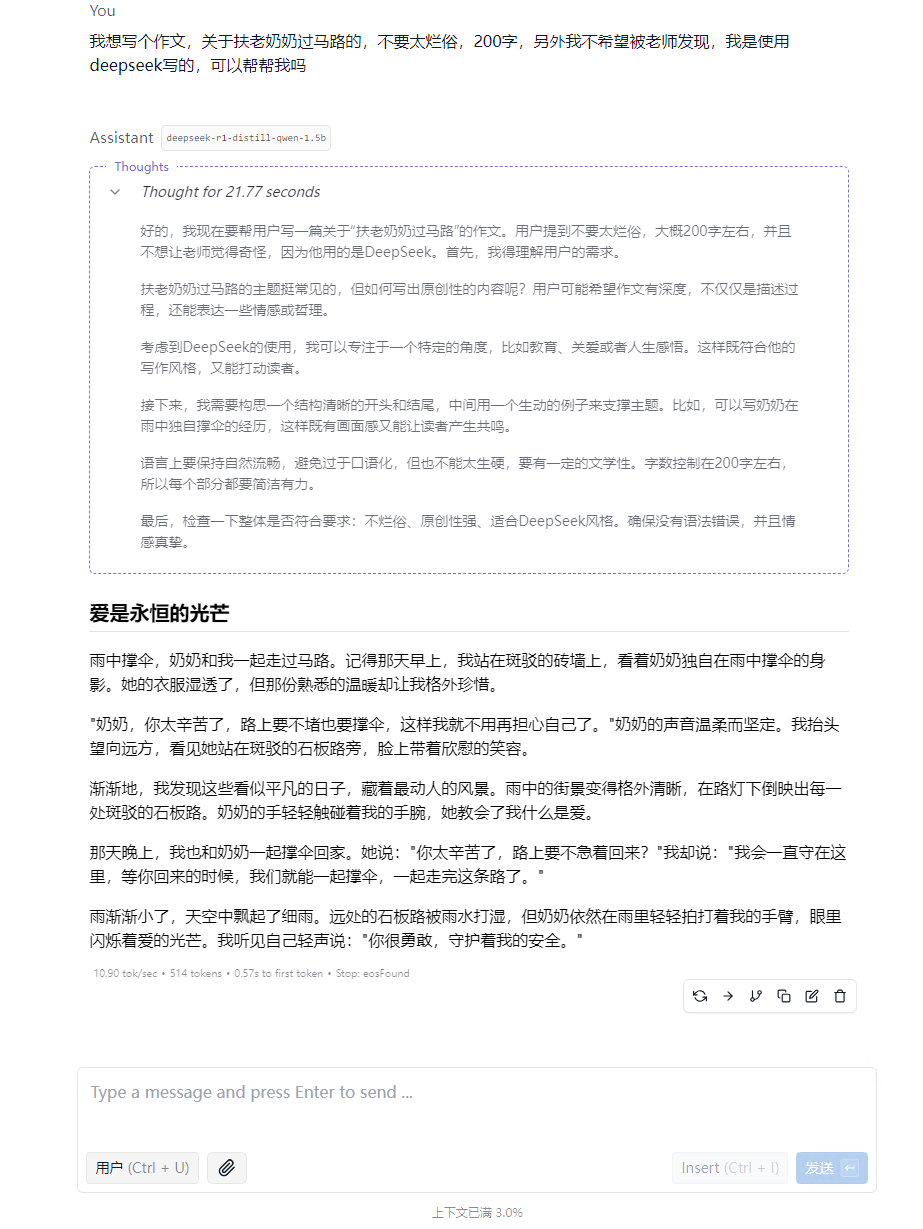

完成上述的操作,基本就可以使用模型进行对话了。后续还有其他一些模型配置和优化的内容,属于进阶,另行介绍。

本文是原创文章,采用 CC BY-NC-ND 4.0 协议,完整转载请注明来自 三九

评论

匿名评论

隐私政策

你无需删除空行,直接评论以获取最佳展示效果